Eye Research hat gezeigt, dass ein AI-Canvas legitime Inhalte imitieren kann, zum Beispiel eine HR Umfrage oder eine interne Login-Seite. Werden diese Canvases Inhalte per E-Mail oder über Messaging Plattformen verbreitet, wirken sie vertrauenswürdig, da sie mit bekannten KI-Diensten verbunden sind. Weitere Details finden Sie im vollständigen technischen Bericht.

Wie AI-Canvases einen neuen, oft übersehenen Cyberrisikofaktor für Unternehmen schaffen

ChatGPT, Google Gemini, Claude.ai. Teams nutzen KI-Plattformen, um Inhalte zu erstellen, Prototypen zu entwickeln, Daten zu analysieren und gemeinsam zu arbeiten. Eine neuere Funktion, sogenannte AI-Canvas, ermöglicht es, HTML-basierte oder anwendungsähnliche Inhalte zu erstellen und über einen einfachen Link öffentlich zu teilen.

So entsteht jedoch eine neue und bislang wenig untersuchte Angriffsfläche, die viele Organisationen noch nicht in ihre Sicherheitsstrategie einbezogen haben.

Eye Security hat kürzlich untersucht, ob gemeinsam genutzte AI-Canvases von Angreifern missbraucht werden könnten.

Was wir dabei identifiziert haben, ist kein Grund zur Panik. Es ist jedoch ein wichtiges Signal für IT-Verantwortliche, dass KI-gestützte Collaboration-Tools die Angriffsfläche oft unbemerkt vergrößern können.

AI-Canvases als Dual-Use-Werkzeuge: Ein neuer Kanal für bekannte Cyberangriffe

Social Engineering gehört weiterhin zu den effektivsten Methoden, um Organisationen zu kompromittieren. Branchenberichte zeigen seit Jahren, dass Phishing und durch Nutzer ausgelöste Malware bei der Mehrzahl erfolgreicher Cybervorfälle eine Rolle spielen. Der Global Threat Report 2025 von CrowdStrike hebt beispielsweise weiterhin Techniken wie FakeCaptcha und ClickFix als verbreitete Methoden für den initialen Zugriff hervor. Der Trendbericht The State of Cyber Incidents 2026 von Eye Security zeigt zudem, dass 70 % der untersuchten Vorfälle Business Email Compromise (BEC) waren, eine Angriffsform, die stark auf Identitäten und Vertrauen angewiesen ist.

Eye Research konnte zeigen, dass ein gemeinsam genutztes AI-Canvas legitime Inhalte wie eine HR-Umfrage oder eine interne Login Seite überzeugend nachahmen kann. Werden solche Links per E-Mail oder über Messaging-Plattformen verteilt, erscheinen sie vertrauenswürdig.

Was Eye Security über die weltweit führenden KI-Plattformen herausgefunden hat

Eye Security analysierte mehrere weit verbreitete KI-Plattformen, die das öffentliche Teilen von Inhalten unterstützen.

ChatGPT: subtile Warnhinweise, die leicht übersehen werden

ChatGPT unterstützt öffentlich teilbare Canvases mit interaktiven HTML Inhalten. Nutzer-Inhalte werden zwar gekennzeichnet, die Warnhinweise sind jedoch subtil und können leicht übersehen werden. Bestimmte Aktionen lösen Berechtigungsabfragen aus, die stark auf das Urteilsvermögen der Anwender angewiesen sind.

Google Gemini gibt klare Warnhinweise aus

Google Gemini erstellt hochwertige interaktive Inhalte und unterstützt die öffentliche Freigabe. AI-Canvases zeigen einen deutlich sichtbaren Hinweis, dass der Inhalt von einem anderen Nutzer erstellt wurde. Dies kann das Risiko von Social Engineering reduzieren.

Claude.ai mit strengen Schutzmechanismen und präventiven Kontrollen

Claude nutzt eine sogenannte Artifacts Funktion, die die Ausführung von Code innerhalb der Plattform erlaubt, jedoch mit deutlich strengeren Schutzmaßnahmen. Die manuelle Codebearbeitung ist eingeschränkt. Automatisierte Prüfungen können eindeutig schädliche Änderungen blockieren. Dieser Ansatz zeigt stärkere präventive Kontrollen.

Weitere KI-Plattformen

Mehrere KI-Plattformen ermöglichen das Teilen generierter Inhalte per Link, auch wenn sie keine vollständige Canvas-Funktionalität bieten. Jeder Dienst, der die öffentliche Freigabe interaktiver oder skriptfähiger Inhalte erlaubt, sollte als Teil der wachsenden Angriffsfläche betrachtet werden.

Zusammenfassend zeigt die Analyse, dass sich das Risiko nicht auf einen einzelnen Anbieter oder eine bestimmte Funktion beschränkt. Es entsteht überall dort, wo öffentliche Freigabe, vertrauenswürdige Domains und ausführbare oder interaktive Inhalte zusammenkommen.

Empfehlungen zur Cybersicherheit: Was Führungsteams jetzt tun können

Der Umgang mit KI-Risiken erfordert keine radikalen Veränderungen. Entscheidend sind klare Zuständigkeiten, Transparenz und der Zugang zu der richtigen Expertise.

KI-Werkzeuge in die Security Governance einbeziehen

KI-Plattformen sollten Bestandteil von Risikoanalysen, Richtlinien und internen Sicherheitsvorgaben sein. Dazu gehört auch ein Verständnis darüber, welche Tools öffentliche Freigaben erlauben und wie Links intern geteilt werden.

Security Awareness Trainings modernisieren

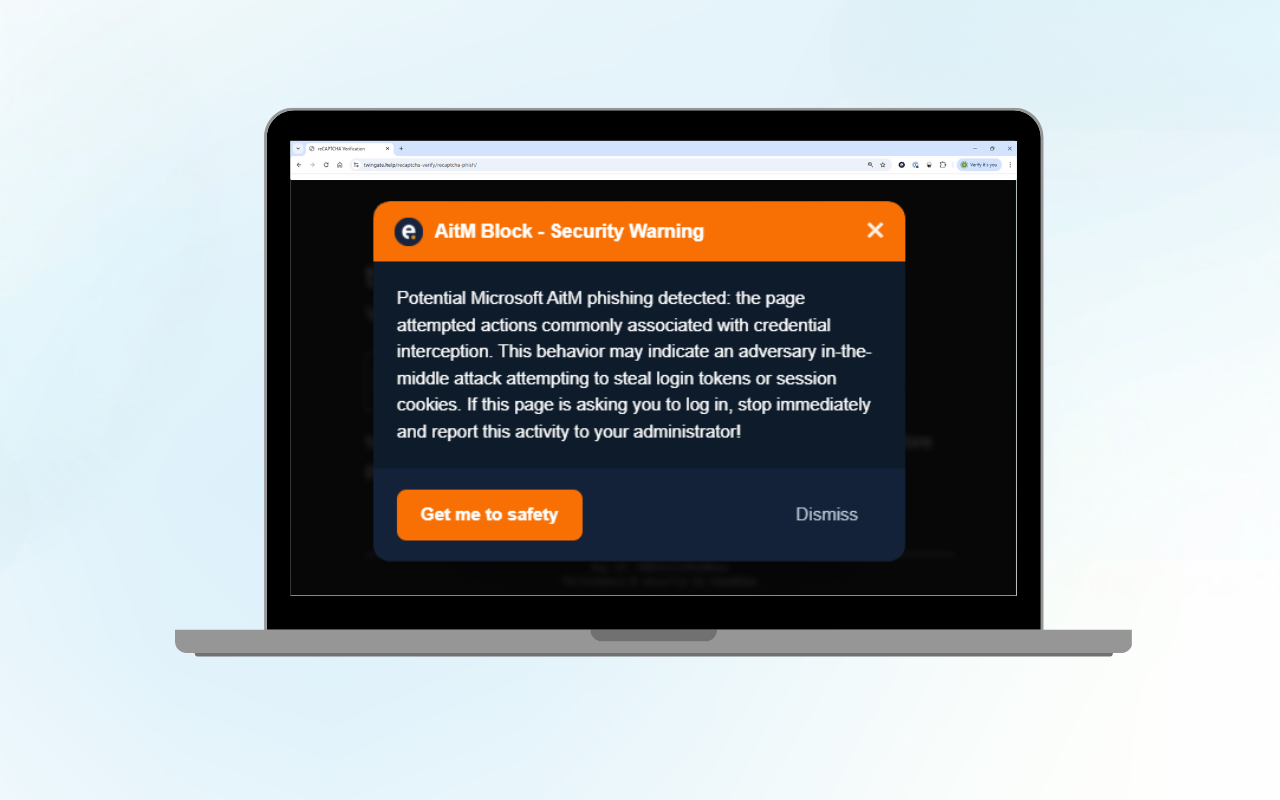

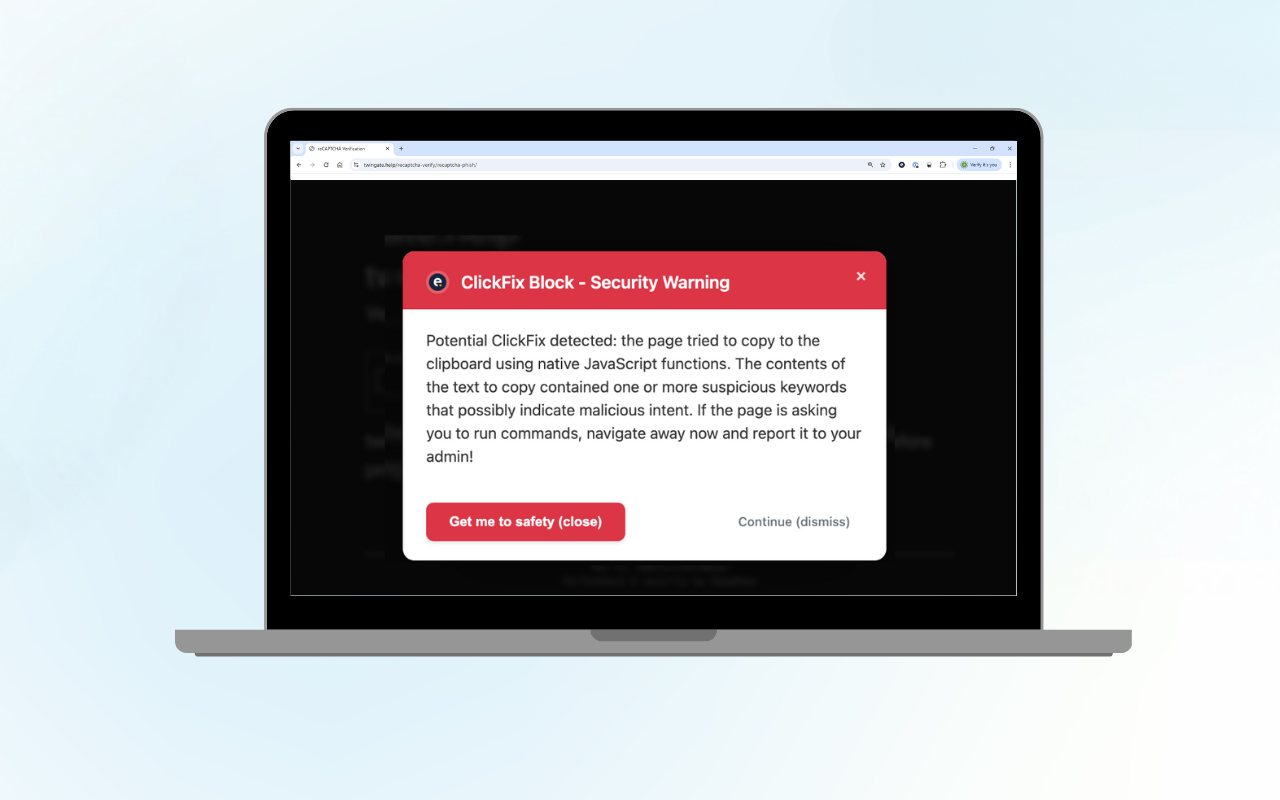

Mitarbeitende sollten darin geschult werden, moderne Phishing Techniken zu erkennen, einschließlich FakeCaptcha und ClickFix Angriffen, die über KI-Plattformen verbreitet werden. Regelmäßige und realistische Simulationen gehören weiterhin zu den wirksamsten Maßnahmen.

Starke Endpoint Detection and Response sicherstellen

Eine gut konfigurierte EDR-Lösung ist entscheidend, um verdächtiges Verhalten zu erkennen, selbst wenn die initiale Interaktion legitim erscheint.

Alarme gründlich untersuchen

Eine schnelle Untersuchung verkürzt die Verweildauer von Angreifern, begrenzt den Schaden und verhindert Wiederholungen.

Transparenz durch ein SIEM aufrechterhalten

Ein SIEM hilft dabei, Aktivitäten aus Endpunkten, Browsern und Cloud Diensten miteinander zu korrelieren. Dieser Kontext ist besonders wichtig, wenn neue Kollaborationskanäle entstehen.

Response und Wiederherstellung vorbereiten

Resilienz bedeutet nicht nur Prävention, sondern auch die Fähigkeit, schnell zu reagieren und den Geschäftsbetrieb wiederherzustellen. Organisationen sollten sowohl auf ihre technischen Reaktionsfähigkeiten als auch auf ihre finanzielle Absicherung vertrauen können.

Innovation absichern, ohne sie auszubremsen

KI-gestützte Produktivitätstools entwickeln sich weiter und verändern die Arbeitswelt nachhaltig. Die Organisationen, die davon am meisten profitieren, verbinden Innovation mit diszipliniertem Risikomanagement.

Neue Technologien schaffen gleichzeitig Chancen und zusätzliche Komplexität. Unsere Aufgabe ist es, Unternehmen dabei zu unterstützen, diese Komplexität mit fundierter Beratung, kontinuierlichem Monitoring und integrierter Absicherung zu bewältigen, die sowohl technische als auch finanzielle Risiken abdeckt.

Häufig gestellte Fragen (FAQ)

Was sind AI-Canvases?

AI-Canvases sind interaktive Arbeitsbereiche innerhalb von KI-Plattformen wie ChatGPT, Google Gemini oder Claude.ai. Sie ermöglichen es, HTML-basierte oder anwendungsähnliche Inhalte über einen einfachen Link zu erstellen und zu teilen. Typische Anwendungsfälle sind Prototypen, Umfragen, Formulare, Dashboards oder kollaborative Dokumente.

Warum sind AI-Canvases aus Sicht der Cybersicherheit relevant?

AI-Canvases schaffen eine neue, oft übersehene Angriffsfläche. Da sie interaktive Inhalte enthalten können und über KI-Plattformen geteilt werden, nehmen Nutzer sie häufig als grundsätzlich sicher wahr. Dieses Vertrauen kann missbraucht werden, um bekannte Social-Engineering-Angriffe über einen neuen Kanal zu verbreiten.

Sind AI-Canvases grundsätzlich unsicher?

Nein. AI-Canvases sind nicht unsicher und es gibt derzeit keine Hinweise auf eine großflächige Ausnutzung. Eye Security untersuchte hypothetische Szenarien in einer kontrollierten Umgebung, um zu verstehen, wie bestehende Angriffstechniken potenziell an neue Plattformfunktionen angepasst werden könnten.

Welche Arten von Angriffen können über AI-Canvases erfolgen?

AI-Canvases ermöglichen keine neuen Angriffstechniken. Sie können jedoch als Verbreitungsmechanismus für bekannte Methoden wie Phishing, FakeCaptcha, ClickFix oder das Abgreifen von Zugangsdaten genutzt werden. Diese Angriffe beruhen in erster Linie auf Vertrauen und nicht auf technischen Schwachstellen.

Welche KI-Plattformen wurden untersucht und welche Unterschiede hat Eye Security festgestellt?

Eye Security hat mehrere weit verbreitete Plattformen analysiert, darunter ChatGPT, Google Gemini und Claude.ai. Ziel war es, Unterschiede in Designentscheidungen, Schutzmechanismen und Nutzerhinweisen zu verstehen.

ChatGPT unterstützt geteilte Canvas mit interaktiven Warnhinweisen, die jedoch subtil sind und übersehen werden können. Google Gemini zeigt klare Hinweise an, wenn Inhalte von anderen Nutzern erstellt wurden, was die Wirksamkeit von Social Engineering verringern kann. Claude.ai setzt mit der Artifacts Funktion auf strengere präventive Kontrollen, darunter eingeschränkte Code-Bearbeitung und automatisierte Prüfungen. Diese Unterschiede zeigen, dass das Risiko nicht allein von der Funktionalität abhängt, sondern auch vom Plattformdesign.

Ist dieses Risiko auf bestimmte KI-Plattform-Anbieter beschränkt?

Nein. Das grundlegende Risiko betrifft jede etablierte KI-Plattform, die öffentliche Inhaltsfreigabe mit interaktiven oder ausführbaren Elementen kombiniert. Mit der fortschreitenden Entwicklung KI-gestützter Kollaborationswerkzeuge werden ähnliche Fragestellungen im gesamten Ökosystem relevant bleiben.