Recent onderzoek van Eye Security laat zien dat gedeelde AI-canvassen overtuigend legitieme zakelijke content kunnen nabootsen, zoals HR-enquêtes of interne inlogpagina’s. Wanneer deze canvassen worden verspreid via e-mail of berichtenplatforms, ogen ze betrouwbaar. Ze zijn immers gehost op domeinen van bekende AI-diensten. En precies dát vertrouwen vormt vandaag de dag de kern van veel succesvolle cyberaanvallen.

In deze blog leggen we uit waarom AI-canvassen geen op zichzelf staand nieuw aanvalstype introduceren, maar wél een nieuw distributiekanaal vormen voor bekende social-engineeringtechnieken, en waarom dat relevant is voor bestuurders en IT-leiders. Lees meer in de volledige technische analyse.

AI-canvassen: productiviteitswinst met een keerzijde

ChatGPT, Google Gemini en Claude.ai zijn inmiddels vaste hulpmiddelen binnen veel organisaties. Teams gebruiken deze platforms om teksten te schrijven, analyses te maken, prototypes te bouwen en samen te werken. Een relatief nieuwe functionaliteit binnen deze tools zijn zogeheten AI-canvassen: interactieve werkruimtes waarin HTML-gebaseerde of applicatie-achtige content kan worden gecreëerd en gedeeld via een eenvoudige link.

Vanuit innovatie en productiviteit is dit een logische en waardevolle ontwikkeling. Tegelijkertijd ontstaat er vanuit cybersecurity een nieuw, grotendeels onontgonnen risico dat in veel beveiligingsstrategieën nog niet expliciet is meegenomen.

Het onderzoeksteam van Eye Security onderzocht recent in hoeverre gedeelde AI-canvassen misbruikt zouden kúnnen worden door aanvallers. De aanleiding is herkenbaar binnen cybersecurity: nieuwe samenwerkingsfunctionaliteiten worden vaak sneller ingevoerd dan governance, beveiligingsmaatregelen en gebruikersbewustzijn kunnen bijhouden.

Onze bevindingen zijn geen reden tot paniek. Ze vormen wél een belangrijk signaal voor bestuurders en IT-leiders om te begrijpen hoe AI-gedreven samenwerkingstools het aanvalsoppervlak ongemerkt kunnen vergroten.

AI-canvassen als nieuw kanaal voor bekende aanvallen

Social engineering blijft een van de meest effectieve manieren om organisaties te compromitteren. Sectorrapporten laten al jaren zien dat phishing, diefstal van inloggegevens en door gebruikers uitgevoerde malware een rol spelen bij het merendeel van de succesvolle incidenten.

Het Global Threat Report 2025 van CrowdStrike wijst opnieuw op technieken zoals FakeCaptcha en ClickFix als veelgebruikte methoden voor initiële toegang. Het trendrapport The State of Cyber Incidents 2026 van Microsoft en Eye Security laat zien dat 70 procent van de onderzochte incidenten draaide om Business Email Compromise, een aanvalsvorm die sterk leunt op identiteit en vertrouwen.

Eye Research toonde aan dat een gedeeld AI-canvas geloofwaardig legitieme zakelijke content kan imiteren, zoals een HR-enquête of een interne inlogpagina. Wanneer dergelijke links via e-mail of berichtenplatforms worden gedeeld, wekken ze vertrouwen omdat ze afkomstig zijn van breed erkende AI-diensten.

Dat is relevant, omdat vertrouwen de kern vormt van moderne aanvallen. Gebruikers zijn doorgaans veel voorzichtiger met onbekende domeinen dan met links die verbonden zijn aan bekende technologiebedrijven.

Wat Eye Research ontdekte over grote AI-platform

Voor dit onderzoek analyseerde Eye Security meerdere veelgebruikte AI-platforms die publieke contentdeling ondersteunen. De bevindingen geven een momentopname weer en zijn bedoeld om ontwerpverschillen zichtbaar te maken, niet om individuele leveranciers aan te wijzen.

ChatGPT: waarschuwingen die makkelijk worden gemist

Ondersteunt publiek deelbare canvassen met interactieve HTML content. Door gebruikers gegenereerde content wordt wel aangeduid, maar de waarschuwingen zijn subtiel en kunnen eenvoudig over het hoofd worden gezien. Bepaalde acties van gebruikers kunnen permissie prompts activeren die sterk leunen op het beoordelingsvermogen van de gebruiker.

Google Gemini: duidelijke gebruikerswaarschuwingen

Google Gemini genereert hoogwaardige interactieve content en ondersteunt publieke deling. Gedeelde canvassen tonen een duidelijke waarschuwing dat de content door een andere gebruiker is gemaakt. Dat verlaagt de kans op misbruik via social engineering.

Claude.ai: strengere preventieve maatregelen

Claude.ai maakt gebruik van een Artifacts-functionaliteit die code-uitvoering binnen het platform mogelijk maakt, maar met strengere beveiliging. Handmatige codebewerking is beperkt en geautomatiseerde scans kunnen duidelijk kwaadaardige aanpassingen blokkeren. Deze aanpak laat zien hoe preventieve controles als standaardinstelling risico kunnen beperken.

Andere AI-platforms

Ook andere platforms ondersteunen het delen van gegenereerde content via links, zelfs als ze geen volledige canvasfunctionaliteit bieden. Elke dienst die publieke deling van interactieve of scriptbare content toestaat, moet worden gezien als onderdeel van het veranderende aanvalsoppervlak.

Samenvattend laat het onderzoek zien dat het risico niet beperkt is tot één leverancier of functie. Het is inherent aan elk platform dat publieke deling, vertrouwde domeinen en uitvoerbare of interactieve content combineert.

Wat leiderschapsteams nu al kunnen doen

Het adresseren van AI-gerelateerde risico’s vraagt geen radicale koerswijziging. Het vraagt om eigenaarschap, duidelijkheid en toegang tot de juiste expertise.

Neem AI-tools op in security governance

AI-platforms die zakelijk worden gebruikt horen binnen de scope te vallen van risicoanalyses, beleid voor acceptabel gebruik en interne beveiligingsrichtlijnen. Dat betekent ook inzicht krijgen in welke tools publieke deling toestaan en hoe links intern worden gedeeld.

Moderniseer security-awarenesstraining

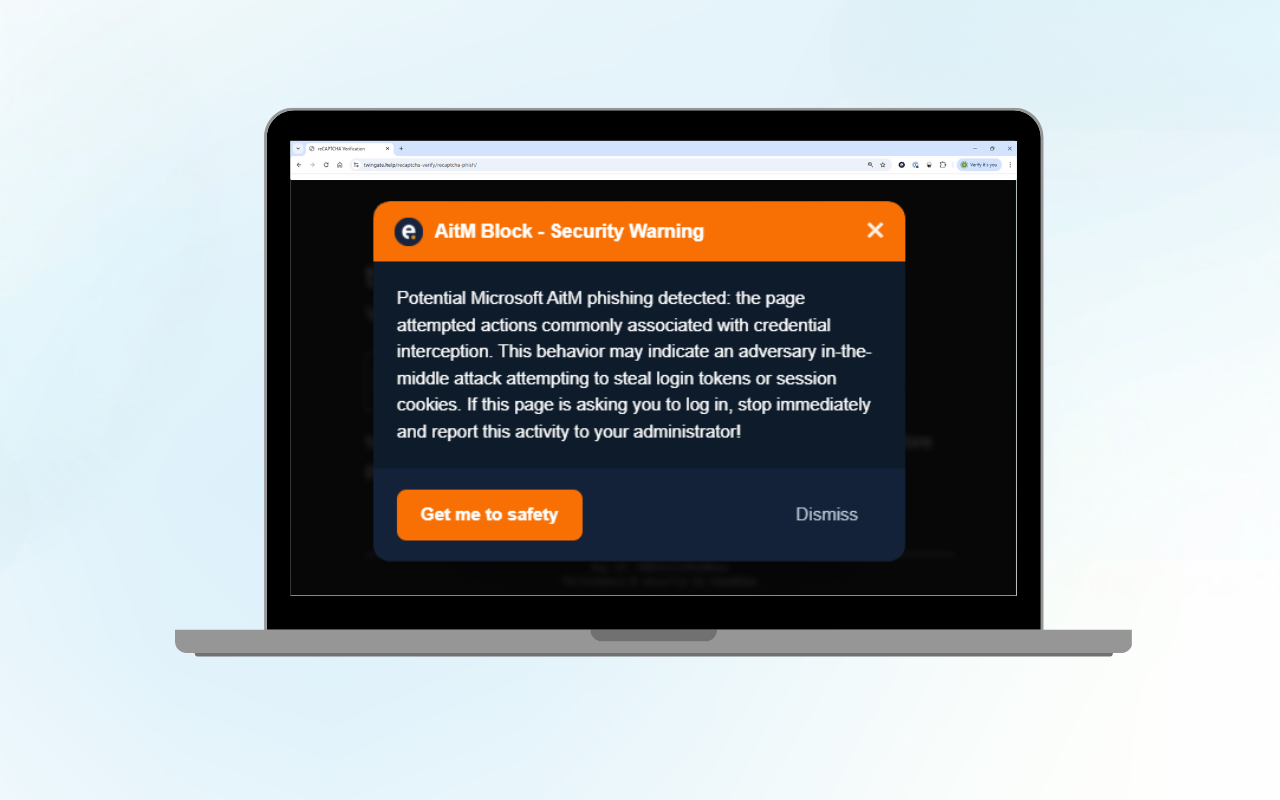

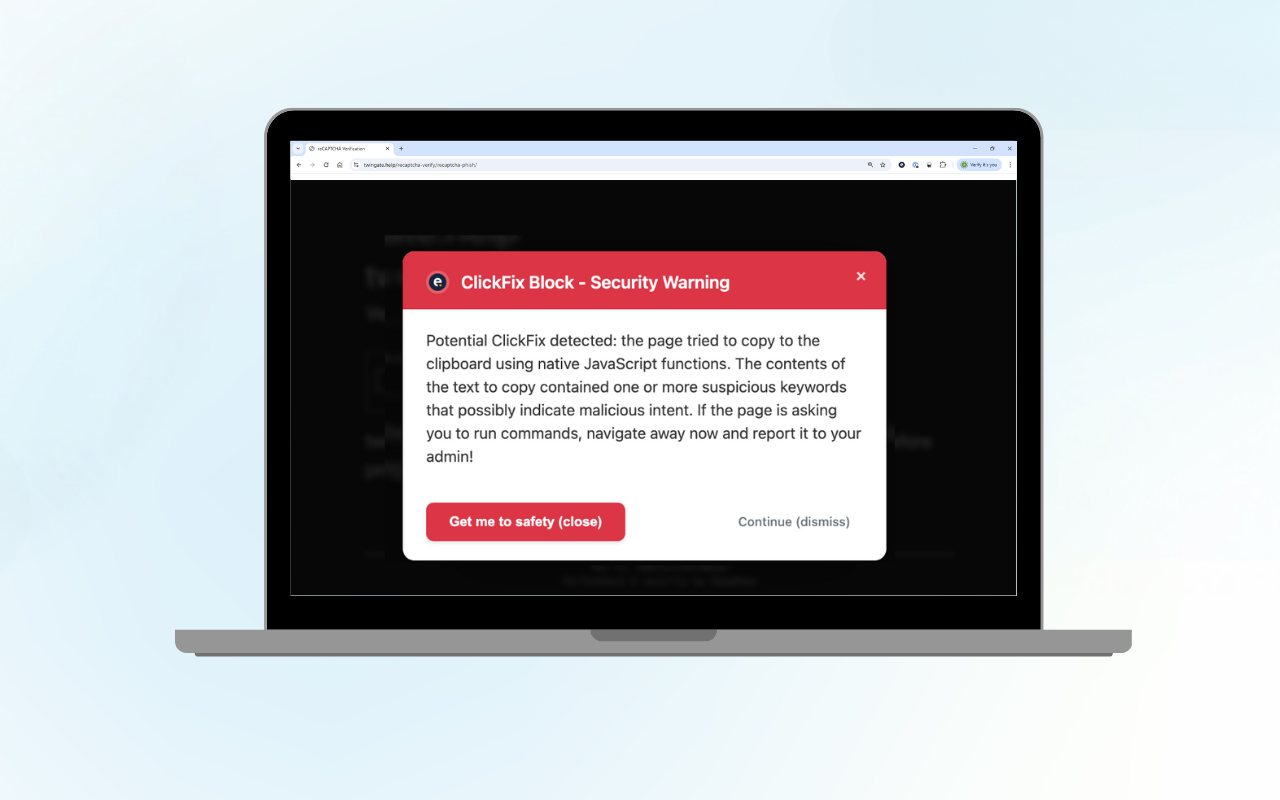

Medewerkers moeten leren om moderne phishingtechnieken te herkennen, waaronder FakeCaptcha- en ClickFix-aanvallen die via vertrouwde platforms worden verspreid. Regelmatige en realistische simulaties blijven hierbij een van de meest effectieve maatregelen.

Zorg voor sterke endpoint detection & response

Wanneer social engineering slaagt, worden endpoints het punt waar kwaadaardige activiteit zichtbaar wordt. Een goed ingerichte en continu gemonitorde EDR-oplossing is essentieel om verdacht gedrag te detecteren, zelfs wanneer de eerste interactie legitiem lijkt.

Onderzoek meldingen consequent

Detectie levert alleen waarde op als meldingen worden beoordeeld door ervaren securityprofessionals. Snelle analyse verkort de verblijftijd van aanvallers, beperkt de impact en voorkomt herhaling.

Behoud centraal overzicht via een SIEM

Een goed afgestemde SIEM helpt om endpoint-, browser- en cloudactiviteiten te correleren. Die context is extra belangrijk wanneer nieuwe distributiekanalen ontstaan.

Bereid je voor op response en herstel

Weerbaarheid draait niet alleen om preventie, maar ook om het vermogen om snel te reageren en te herstellen. Organisaties moeten vertrouwen hebben in zowel hun technische respons als hun financiële paraatheid.

Innovatie beveiligen zonder deze te vertragen

AI-gedreven productiviteitstools zijn blijvend. Ze blijven zich ontwikkelen en veranderen de manier waarop we werken. Organisaties die hier het meeste voordeel uit halen, combineren innovatie met gedisciplineerd risicomanagement.

Bij Eye Security zien we dit als een herkenbare uitdaging. Nieuwe technologie vergroot kansen én complexiteit tegelijk. Onze rol is om organisaties te helpen die complexiteit te beheersen met rustige, deskundige begeleiding, continue monitoring en geïntegreerde bescherming die zowel technisch als financieel risico afdekt.

Door 24/7 door experts geleide detectie en respons te combineren met security-geïnformeerde cyberverzekering, helpen we leiderschapsteams om vertrouwen te behouden, ook wanneer het aanvalsoppervlak verandert.

Noot van de redactie: AI-canvassen zijn niet per definitie onveilig en er is momenteel geen bewijs van grootschalig misbruik van deze functionaliteiten. De scenario’s die Eye Security onderzocht zijn hypothetisch en uitgevoerd in een gecontroleerde onderzoeksomgeving. Cyberrisico’s ontstaan echter vaak geleidelijk, wanneer nieuwe platformmogelijkheden worden gecombineerd met bekende aanvalstechnieken. Vanuit dat perspectief gebruiken we AI-canvassen als vroegtijdig signaal om te laten zien hoe vertrouwde tools misbruikt kunnen worden wanneer beveiligingsontwerp, gebruikersbewustzijn en monitoring niet gelijktijdig meegroeien met innovatie.

Veelgestelde vragen: AI canvassen en cyberrisico

Wat zijn AI canvassen?

AI canvassen zijn interactieve werkruimtes binnen AI platforms zoals ChatGPT, Google Gemini en Claude.ai. Ze maken het mogelijk om HTML gebaseerde of applicatie achtige content te creëren en te delen via een eenvoudige link. Veelvoorkomende toepassingen zijn prototypes, enquêtes, formulieren, dashboards en samenwerkingsdocumenten.

Waarom zijn AI canvassen relevant vanuit cybersecurity perspectief?

AI canvassen introduceren een nieuw en vaak over het hoofd gezien aanvalsoppervlak. Omdat ze interactieve content kunnen bevatten en worden gedeeld via vertrouwde AI platform domeinen, worden ze door gebruikers vaak als veilig beschouwd. Dat vertrouwen kan worden misbruikt om bekende social engineering aanvallen via een nieuw kanaal te verspreiden.

Zijn AI canvassen per definitie onveilig?

Nee. AI canvassen zijn niet inherent onveilig en er is momenteel geen bewijs van grootschalig misbruik in de praktijk. Het onderzoek van Eye Security verkende hypothetische scenario’s in een gecontroleerde omgeving om te begrijpen hoe bestaande aanvalstechnieken zich mogelijk aanpassen aan nieuwe platformmogelijkheden.

Welke soorten aanvallen kunnen via AI canvassen worden verspreid?

AI canvassen maken geen nieuwe aanvalstechnieken mogelijk. Ze kunnen wel worden gebruikt als distributiemechanisme voor bekende methoden zoals phishing, FakeCaptcha, ClickFix en het verzamelen van inloggegevens. Deze aanvallen vertrouwen vooral op gebruikersvertrouwen, niet op technische kwetsbaarheden.

Welke AI platforms zijn onderzocht en welke verschillen zag Eye Research?

Eye Security analyseerde meerdere veelgebruikte platforms die publieke contentdeling toestaan, waaronder ChatGPT, Google Gemini en Claude.ai. Het doel was om verschillen in ontwerpkeuzes, beveiligingsmaatregelen en gebruikerswaarschuwingen te begrijpen, niet om individuele leveranciers aan te wijzen.

Het onderzoek liet duidelijke verschillen zien. ChatGPT ondersteunt gedeelde canvassen met interactieve content, maar de waarschuwingen voor gebruikers zijn subtiel en kunnen worden gemist. Google Gemini toont duidelijke waarschuwingen wanneer content door een andere gebruiker is gemaakt, wat de effectiviteit van social engineering kan verminderen. Claude.ai hanteert strengere preventieve maatregelen via de Artifacts functionaliteit, waaronder beperkte codebewerking en geautomatiseerde scans. Deze verschillen maken duidelijk dat risico niet alleen wordt bepaald door functionaliteit, maar ook door platformontwerp.

Is dit risico beperkt tot specifieke AI platform leveranciers?

Nee. Het onderliggende risico geldt voor elk platform dat publieke contentdeling, vertrouwde domeinen en interactieve of uitvoerbare elementen combineert. Naarmate AI gedreven samenwerkingstools zich verder ontwikkelen, zullen vergelijkbare aandachtspunten in het hele ecosysteem blijven gelden.